- L’institut

- Activités

- L’IMI et vous

- Évènements

- Ressources

- Les Amis de l’IMI

- Contact

FR

FR

« Does psiThouless et Wiesner ont introduit en 1942 lexpression "Phénomène psi" (et non "psy"), de la lettre grecque Psi, qui se voulait un terme neutre simplement destiné à désigner le "facteur inconnu" dans les expériences de parapsychologie, en opposition avec les communications sensori-motrices habituelles. On utilise ainsi le terme psi comme signifiant de façon générale une communication anormale avec lenvironnement (perceptions extra-sensorielles ou psychokinèse). On utilise fréquemment en parapsychologie les expressions de sujet psi, de perceptions psi et de phénomènes psi. exist ? » fut publié dans le Psychological Bulletin en 1994. Il a été co-écrit par Charles Honorton, l’un des pionniers de la recherche en parapsychologieEtude rationnelle et pluridisciplinaire des faits semblant inexplicables dans l'état actuel de nos connaissances, et mettant en jeu directement le psychisme et son interaction avec l'environnement. C'est en 1889 que l'Allemand Max DESSOIR proposa les termes de parapsychologie pour "caractériser toute une région frontière encore inconnue qui sépare les états psychologiques habituels des états pathologiques", et de paraphysique pour désigner des phénomènes objectifs qui paraissent échapper aux lois de la physique classique. On parle plus spécifiquement de parapsychologie expérimentale pour désigner la parapsychologie dans le cadre du laboratoire. More, et Daryl J. Bem, professeur de psychologie à l’Université de Cornell. Ces deux chercheurs y exposent les résultats obtenus avec le protocole le plus utilisé en parapsychologieEtude rationnelle et pluridisciplinaire des faits semblant inexplicables dans l'état actuel de nos connaissances, et mettant en jeu directement le psychisme et son interaction avec l'environnement. C'est en 1889 que l'Allemand Max DESSOIR proposa les termes de parapsychologie pour "caractériser toute une région frontière encore inconnue qui sépare les états psychologiques habituels des états pathologiques", et de paraphysique pour désigner des phénomènes objectifs qui paraissent échapper aux lois de la physique classique. On parle plus spécifiquement de parapsychologie expérimentale pour désigner la parapsychologie dans le cadre du laboratoire. More jusqu’en 1994 : le Ganzfeld. Depuis, le nombre d’expériences de GanzfeldLe Ganzfeld (terme allemand qui signifie "champ sensoriel uniforme") est un protocole dinduction détat hypnagogique pour les expériences de télépathie. Le Ganzfeld est le protocole le plus utilisé actuellement en parapsychologie expérimentale. Il a été tout d'abord développé par Charles Honorton dans les années 1970. effectuées a encore augmenté (plus d’une centaine ont été réalisées). Vous trouverez à la suite de cet article quelques liens vers d’autres publications sur le sujet, notamment celle d’Etzel Cardena de mai 2018.

Résumé

La plupart des psychologues ne reconnaissent pas encore la réalité du « psi », c’est à dire les transfert d’informations ou d’énergie (comme la télépathieLa télépathie désigne un échange dinformations entre deux personnes nimpliquant aucune interaction sensorielle ou énergétique connue. ou d’autres formes de perceptions extra-sensoriellesConnaissance dun événement extérieur sans lintervention des sens connus, ou parfois comportement répondant à cet événement. On distingue la télépathie, la clairvoyance et la précognition.) qui ne sont pas expliqués actuellement par des lois physiques ou par des processus biologiques connus. Nous pensons que les résultats et les effets mesurés lors d’un protocole expérimental spécifique, le « ganzfeld », sont à présent suffisamment convaincants pour être portés à l’attention de l’ensemble de la communauté psychologique. Des méta-analyses des résultats du ganzfeldLe Ganzfeld (terme allemand qui signifie "champ sensoriel uniforme") est un protocole dinduction détat hypnagogique pour les expériences de télépathie. Le Ganzfeld est le protocole le plus utilisé actuellement en parapsychologie expérimentale. Il a été tout d'abord développé par Charles Honorton dans les années 1970. ont été effectuées, l’une par Ray Hyman (1985), observateur sceptique à propos des recherches sur les phénomènes psiThouless et Wiesner ont introduit en 1942 lexpression "Phénomène psi" (et non "psy"), de la lettre grecque Psi, qui se voulait un terme neutre simplement destiné à désigner le "facteur inconnu" dans les expériences de parapsychologie, en opposition avec les communications sensori-motrices habituelles. On utilise ainsi le terme psi comme signifiant de façon générale une communication anormale avec lenvironnement (perceptions extra-sensorielles ou psychokinèse). On utilise fréquemment en parapsychologie les expressions de sujet psi, de perceptions psi et de phénomènes psi. et l’autre par Charles HonortonCharles Honorton s'est intéressé très tôt à la parapsychologie. Adolescent, il échangea avec Joseph Rhine, et étudiant, il passa ses mois d'été au Laboratoire de Parapsychologie d’université de Duke en Caroline du Nord. Charles Honorton collabora avec Stanley Krippner et Montague Ullman au Maimonides Medical Center (Brooklyn, New York) lors des expériences de Rêve télépathique. Devenu directeur de la division de parapsychologie au Maimonides, il fonda en 1979 le Psychophysical Research Laboratories (PRL) à Princeton dans le New Jersey. Il est décédé en 1992 laissant derrière lui un nombre important de publications de parapsychologie, sa principale contribution en parapsychologie étant le développement du protocole Ganzfeld. More (1985), parapsychologueCe terme revêt de nos jours un double sens. Utilisé pour désigner les chercheurs de formation scientifique et universitaire qui étudient les phénomènes paranormaux dans le cadre de la parapsychologie scientifique, il renvoie aussi aux praticiens de l'occulte et du paranormal (voyants, médiums, magnétiseurs, etc.). On pourrait souhaiter que la première acception évoquée l'emporte dans le vocabulaire courant pour ainsi éviter toute confusion. L'ambiguïté du terme est volontiers entretenue par les critiques et détracteurs de la parapsychologie scientifique. Ceux-ci tentent ainsi, par un pernicieux effet d'amalgame maintenant une certaine confusion sémantique, de reléguer des recherches se voulant rationnelles sur ces questions en dehors du champ de la science. Des praticiens du paranormal peuvent avoir tendance, eux aussi, à entretenir cette ambiguïté. En se prétendant parapsychologues, ils espèrent sans doute, par la référence scientifique qu'ils s'attribuent, renforcer auprès de leurs clients l'image de professions en manque de reconnaissance sociale. De plus, le peu d'approfondissement que des enquêtes médiatiques trop souvent en mal de sensationnel consacrent à ce type de questions contribue à laisser perdurer la confusion, là où il faudrait au contraire faire preuve de discernement et de prudence. Que pouvons-nous dire des parapsychologues relevant du premier sens envisagé et que nous voudrions privilégier ici? D'origines universitaires variées, les chercheurs amenés à réfléchir aux questions parapsychologiques se recrutent aussi bien parmi des spécialistes des sciences dites humaines (psychologues, ethnologues, sociologues, etc.) que parmi des spécialistes des sciences dites exactes (mathématiciens, physiciens, biologistes, etc.). Des philosophes, des médecins et des ingénieurs se retrouvent également impliqués dans ce domaine de recherche. Seuls quelques laboratoires dans le monde emploient des chercheurs en parapsychologie à temps plein. Compte tenu du peu de place que l'institution scientifique accorde encore à la parapsychologie, la plupart des chercheurs n'y consacrent qu'une partie de leur temps, exerçant par ailleurs des fonctions en lien avec leur formation d'origine. Les premiers grands noms de la parapsychologie furent les pionniers de recherches qualifiées alors de psychiques , ou bien encore de métapsychiques. Parmi les plus connus, on pourrait citer le philosophe américain William James (1842-1910), tenant du pragmatisme, le physicien anglais William Crookes (1829-1919), rendu par ailleurs célèbre par la découverte du thallium, et le Français Charles Richet (1850-1935), prix Nobel de médecine en 1913. Deux psychologues américains ont ensuite particulièrement marqué l'histoire de la parapsychologie durant la seconde moitié du XXème siècle. Joseph Banks Rhine (1925-1980) est considéré comme le père de la parapsychologie quantitative car il a systématisé le traitement statistique des phénomènes paranormaux observés en laboratoire. Plus près de nous, Charles Honorton, en introduisant la technique du ganzfeld et en appliquant les techniques de méta-analyses aux données parapsychologiques, a permis de faire avancer le débat entre partisans et opposants de la parapsychologie. En France, c'est essentiellement autour de l'Institut métapsychique international, fondé en 1919, que se sont regroupés les principaux intellectuels interessés par ces questions. On citera, pour mémoire, les docteurs Gustave Geley (1865-1924) et Eugène Osty (1874-1938) ou bien encore les ingénieurs René Warcollier (1881-1962) et Henri Marcotte (1920-1987). Le spécialiste d'éthologie animale Rémy Chauvin, membre de l'Académie des sciences, est certainement, à l'heure actuelle, le scientifique le plus connu du grand public qui ait ouvertement déclaré son intérêt pour la parapsychologie, par le biais notamment d'expériences réalisées avec des animaux. Ce sont en fait de très nombreux chercheurs (qu'il faudrait certainement compter en milliers), issus de mondes scientifiques et intellectuels très divers, qui se sont passionnés pour la parapsychologie depuis plus d'un siècle, aussi bien en Europe qu'aux États-Unis, comme dans l'ex-URSS ou d'autres pays du monde. Dans son ouvrage "Somnambulisme et médiumnité" et plus particulièrement dans le tome II intitulé "Le Choc des sciences psychiques", le philosophe et sociologue Bertrand Meheust, reprenant l'histoire des débuts de la métapsychique, tente de comprendre les origines de l'incroyable entreprise d'occultation qui a pesé et qui pèse encore sur les travaux de plusieurs générations de parapsychologues. {Par Paul-Louis Rabeyron (extrait du dictionnaire des miracles et de l'extraordinaire chrétien, rédigé sous la direction de Patrick Sbalchiero, Fayard, 2000)} ayant contribué de façon majeure aux expériences de ganzfeldLe Ganzfeld (terme allemand qui signifie "champ sensoriel uniforme") est un protocole dinduction détat hypnagogique pour les expériences de télépathie. Le Ganzfeld est le protocole le plus utilisé actuellement en parapsychologie expérimentale. Il a été tout d'abord développé par Charles Honorton dans les années 1970.. Puis, nous proposons dans cet article un résumé des résultats de 11 nouvelles recherches ganzfeldLe Ganzfeld (terme allemand qui signifie "champ sensoriel uniforme") est un protocole dinduction détat hypnagogique pour les expériences de télépathie. Le Ganzfeld est le protocole le plus utilisé actuellement en parapsychologie expérimentale. Il a été tout d'abord développé par Charles Honorton dans les années 1970. qui se conforment aux indications rédigées conjointement par R.Hyman et C.Honorton (1986). Enfin, nous aborderons le problème de la reproductibilitéPossibilité de reproduire des résultats identiques ou similaires dans des expérimentations de même type. et des explications théoriques de ces phénomènes.

Le terme « psi » désigne un processus anormal de transfert d’information ou d’énergie, processus comme la télépathieLa télépathie désigne un échange dinformations entre deux personnes nimpliquant aucune interaction sensorielle ou énergétique connue. ou d’autres formes de perceptions extra-sensoriellesConnaissance dun événement extérieur sans lintervention des sens connus, ou parfois comportement répondant à cet événement. On distingue la télépathie, la clairvoyance et la précognition. qui demeurent à l’heure actuelle inexpliquées sur les plans physiques et biologiques. Ce terme est purement descriptif : il n’implique nullement que de tels phénomènes soient paranormaux et n’a pas de connotations sur l’explication de leurs processus.

Le psiThouless et Wiesner ont introduit en 1942 lexpression "Phénomène psi" (et non "psy"), de la lettre grecque Psi, qui se voulait un terme neutre simplement destiné à désigner le "facteur inconnu" dans les expériences de parapsychologie, en opposition avec les communications sensori-motrices habituelles. On utilise ainsi le terme psi comme signifiant de façon générale une communication anormale avec lenvironnement (perceptions extra-sensorielles ou psychokinèse). On utilise fréquemment en parapsychologie les expressions de sujet psi, de perceptions psi et de phénomènes psi. existe-t-il ? La plupart des psychologues universitaires pensent que non. Un sondage montre que plus de 1100 professeurs d’université aux Etats-Unis, dont 55% en sciences naturelles, 66% en sciences sociales (sauf en psychologie) et 77% des universitaires en Lettres, Sciences Humaines et Sciences de l’éducation se représentent le psiThouless et Wiesner ont introduit en 1942 lexpression "Phénomène psi" (et non "psy"), de la lettre grecque Psi, qui se voulait un terme neutre simplement destiné à désigner le "facteur inconnu" dans les expériences de parapsychologie, en opposition avec les communications sensori-motrices habituelles. On utilise ainsi le terme psi comme signifiant de façon générale une communication anormale avec lenvironnement (perceptions extra-sensorielles ou psychokinèse). On utilise fréquemment en parapsychologie les expressions de sujet psi, de perceptions psi et de phénomènes psi. comme un fait établi ou étant vraisemblablement possible. En comparaison, seulement 34% des psychologues sont du même avis. De plus, ils sont aussi nombreux à déclarer que les phénomènes « psi » sont impossibles, point de vue exprimé par seulement 2% de toutes les autres personnes sondées. (Wagner et Monnet, 1979)

En tant que psychologues, nous sommes probablement bien plus sceptiques en la matière que l’ensemble de la population et ceci pour plusieurs raisons. Premièrement, nous estimons que les affirmations extraordinaires exigent des preuves extraordinaires. Et, bien que nos collègues dans d’autres disciplines puissent être d’accord avec ce dicton, nous sommes particulièrement attentifs aux exigences méthodologiques et statistiques afin de prouver de telles choses, car de précédentes allégations n’ont pas survécu à nos exigences ni satisfait aux essais de reproduction. Même pour des assertions ordinaires, nos critères statistiques standards sont prudents. Le sacro-saint p=0.05 nous rappelle constamment qu’il est bien plus problématique d’affirmer qu’un effet existe alors qu’il n’existe pas (l’erreur de type 1) que d’affirmer qu’un effet n’existe pas alors qu’il existe vraiment (erreur de type 2).

Deuxièmement, la plupart des psychologues distinguent les phénomènes dont les explications demeurent peu claires ou controversées (par exemple l’hypnose) des phénomènes comme le « psi » qui semblent échapper à nos cadres théoriques (certains verront cela comme la différence existant entre l’inexpliqué et l’inexplicable). A l’inverse, les personnes sans formation en psychologie tendent à traiter sur le même plan épistémologique tous les phénomènes psychologiques un tant soit peu exotiques ; beaucoup considèrent par exemple le « déjà-vu » comme un phénomène psiThouless et Wiesner ont introduit en 1942 lexpression "Phénomène psi" (et non "psy"), de la lettre grecque Psi, qui se voulait un terme neutre simplement destiné à désigner le "facteur inconnu" dans les expériences de parapsychologie, en opposition avec les communications sensori-motrices habituelles. On utilise ainsi le terme psi comme signifiant de façon générale une communication anormale avec lenvironnement (perceptions extra-sensorielles ou psychokinèse). On utilise fréquemment en parapsychologie les expressions de sujet psi, de perceptions psi et de phénomènes psi.. Le manque de clarté au niveau de cette distinction est amplifié par les médias, les livres « new-age », les programmes de développement personnel ainsi que les « voyants » qui proposent à la fois hypnose authentique et pseudo « télépathie ». Ainsi une part du public n’aurait pas à revoir sa conception de la réalité aussi radicalement que nous pour assimiler l’existence du psiThouless et Wiesner ont introduit en 1942 lexpression "Phénomène psi" (et non "psy"), de la lettre grecque Psi, qui se voulait un terme neutre simplement destiné à désigner le "facteur inconnu" dans les expériences de parapsychologie, en opposition avec les communications sensori-motrices habituelles. On utilise ainsi le terme psi comme signifiant de façon générale une communication anormale avec lenvironnement (perceptions extra-sensorielles ou psychokinèse). On utilise fréquemment en parapsychologie les expressions de sujet psi, de perceptions psi et de phénomènes psi.. Pour nous, psychologues, l’existence du « psi » paraît encore plus extraordinaire.

Enfin, les recherches en psychologie sociale et cognitive nous ont rendus particulièrement attentifs vis-à-vis des biaisPrésence de patterns ou de défauts particuliers pouvant introduire une modification arbitraire des résultats et faussant ainsi leur validité (ex : un dé non équilibré ayant tendance à faire sortir souvent le même chiffre). qui entachent fréquemment les tentatives visant à tirer des conclusions à partir de données issues d’expériences quotidiennes. (Gilovich, 1991 ; Nisbett et Ross, 1980, Tversky et Kahneman, 1971). Cela nous amène à ne donner pratiquement aucune crédibilité aux témoignages de phénomènes psiThouless et Wiesner ont introduit en 1942 lexpression "Phénomène psi" (et non "psy"), de la lettre grecque Psi, qui se voulait un terme neutre simplement destiné à désigner le "facteur inconnu" dans les expériences de parapsychologie, en opposition avec les communications sensori-motrices habituelles. On utilise ainsi le terme psi comme signifiant de façon générale une communication anormale avec lenvironnement (perceptions extra-sensorielles ou psychokinèse). On utilise fréquemment en parapsychologie les expressions de sujet psi, de perceptions psi et de phénomènes psi. ou aux articles de journaux, principale source citée par nos collègues d’autres disciplines comme élément en faveur de leur croyance au psiThouless et Wiesner ont introduit en 1942 lexpression "Phénomène psi" (et non "psy"), de la lettre grecque Psi, qui se voulait un terme neutre simplement destiné à désigner le "facteur inconnu" dans les expériences de parapsychologie, en opposition avec les communications sensori-motrices habituelles. On utilise ainsi le terme psi comme signifiant de façon générale une communication anormale avec lenvironnement (perceptions extra-sensorielles ou psychokinèse). On utilise fréquemment en parapsychologie les expressions de sujet psi, de perceptions psi et de phénomènes psi. (Wagner et Monnet, 1979).

Pourtant, paradoxalement, les psychologues ne connaissent guère mieux que le public les récentes recherches expérimentales sur les phénomènes psiThouless et Wiesner ont introduit en 1942 lexpression "Phénomène psi" (et non "psy"), de la lettre grecque Psi, qui se voulait un terme neutre simplement destiné à désigner le "facteur inconnu" dans les expériences de parapsychologie, en opposition avec les communications sensori-motrices habituelles. On utilise ainsi le terme psi comme signifiant de façon générale une communication anormale avec lenvironnement (perceptions extra-sensorielles ou psychokinèse). On utilise fréquemment en parapsychologie les expressions de sujet psi, de perceptions psi et de phénomènes psi.. Comme l’essentiel de la recherche en psychologie, la recherche en parapsychologieEtude rationnelle et pluridisciplinaire des faits semblant inexplicables dans l'état actuel de nos connaissances, et mettant en jeu directement le psychisme et son interaction avec l'environnement. C'est en 1889 que l'Allemand Max DESSOIR proposa les termes de parapsychologie pour "caractériser toute une région frontière encore inconnue qui sépare les états psychologiques habituels des états pathologiques", et de paraphysique pour désigner des phénomènes objectifs qui paraissent échapper aux lois de la physique classique. On parle plus spécifiquement de parapsychologie expérimentale pour désigner la parapsychologie dans le cadre du laboratoire. More n’est publiée que dans des revues spécialisées ; cependant, contrairement aux recherches en psychologie, il n’est pas fait mention de ces travaux dans les manuels, les ouvrages ni dans les principales revues de psychologie. Par exemple, un seul manuel d’introduction en psychologie sur les 64 récemment répertoriés mentionne le ganzfeldLe Ganzfeld (terme allemand qui signifie "champ sensoriel uniforme") est un protocole dinduction détat hypnagogique pour les expériences de télépathie. Le Ganzfeld est le protocole le plus utilisé actuellement en parapsychologie expérimentale. Il a été tout d'abord développé par Charles Honorton dans les années 1970., alors que ce protocole est largement utilisé depuis le début des années 1970 (Roig, Icochea, Cuzzucoli, 1991). En outre, d’autres sources destinées aux non-spécialistes fournissent des informations souvent inexactes au sujet des recherches en parapsychologieEtude rationnelle et pluridisciplinaire des faits semblant inexplicables dans l'état actuel de nos connaissances, et mettant en jeu directement le psychisme et son interaction avec l'environnement. C'est en 1889 que l'Allemand Max DESSOIR proposa les termes de parapsychologie pour "caractériser toute une région frontière encore inconnue qui sépare les états psychologiques habituels des états pathologiques", et de paraphysique pour désigner des phénomènes objectifs qui paraissent échapper aux lois de la physique classique. On parle plus spécifiquement de parapsychologie expérimentale pour désigner la parapsychologie dans le cadre du laboratoire. More (à ce sujet, voir Child, 1985 et Palmer, Honorton et Utts, 1989).

Cette situation est peut-être en train de changer. Des discussions sur la recherche psiThouless et Wiesner ont introduit en 1942 lexpression "Phénomène psi" (et non "psy"), de la lettre grecque Psi, qui se voulait un terme neutre simplement destiné à désigner le "facteur inconnu" dans les expériences de parapsychologie, en opposition avec les communications sensori-motrices habituelles. On utilise ainsi le terme psi comme signifiant de façon générale une communication anormale avec lenvironnement (perceptions extra-sensorielles ou psychokinèse). On utilise fréquemment en parapsychologie les expressions de sujet psi, de perceptions psi et de phénomènes psi. moderne ont récemment été abordées dans un manuel d’introduction très courant (Atkinson, Smith & Bem, 1990, 1993), dans deux journaux « mainstream » de psychologie (Child, 1985, Rao et Palmer, 1987) ainsi que dans un livre universitaire néanmoins accessible aux non spécialistes (Brouhgton, 1991). Le but du présent article est d’appuyer cette extension des publications en proposant une présentation plus détaillée, notamment sur le plan des méta-analyses, des résultats issus d’une méthode unique d’expérimentation : la procédure ganzfeldLe Ganzfeld (terme allemand qui signifie "champ sensoriel uniforme") est un protocole dinduction détat hypnagogique pour les expériences de télépathie. Le Ganzfeld est le protocole le plus utilisé actuellement en parapsychologie expérimentale. Il a été tout d'abord développé par Charles Honorton dans les années 1970.. Nous pensons que le taux de reproductibilitéPossibilité de reproduire des résultats identiques ou similaires dans des expérimentations de même type. et les tailles d’effets mesurés à l’aide de cette procédure expérimentale sont à présent suffisants pour être portés à l’attention de l’ensemble de la communauté des psychologues.

Dans les années 1960, un certain nombre de parapsychologues n’étaient plus satisfaits des méthodes standard de tests ESPPerception extrasensorielle ; connaissance d’un événement extérieur sans l’intervention des sens connus, ou parfois comportement répondant à cet événement. More instaurées par JB Rhine, à l’Université de Duke, dans les années 1930. Ils pensaient en particulier que la répétition de protocoles à choix forcés, dans lesquels un sujet tente de façon répétée de sélectionner le symbole « cible » correct parmi plusieurs autres, ne permettait pas de mettre en oeuvre les conditions qui caractérisent les expériences psiThouless et Wiesner ont introduit en 1942 lexpression "Phénomène psi" (et non "psy"), de la lettre grecque Psi, qui se voulait un terme neutre simplement destiné à désigner le "facteur inconnu" dans les expériences de parapsychologie, en opposition avec les communications sensori-motrices habituelles. On utilise ainsi le terme psi comme signifiant de façon générale une communication anormale avec lenvironnement (perceptions extra-sensorielles ou psychokinèse). On utilise fréquemment en parapsychologie les expressions de sujet psi, de perceptions psi et de phénomènes psi. de la vie quotidienne.

Historiquement, le psiThouless et Wiesner ont introduit en 1942 lexpression "Phénomène psi" (et non "psy"), de la lettre grecque Psi, qui se voulait un terme neutre simplement destiné à désigner le "facteur inconnu" dans les expériences de parapsychologie, en opposition avec les communications sensori-motrices habituelles. On utilise ainsi le terme psi comme signifiant de façon générale une communication anormale avec lenvironnement (perceptions extra-sensorielles ou psychokinèse). On utilise fréquemment en parapsychologie les expressions de sujet psi, de perceptions psi et de phénomènes psi. a souvent été associé à la méditation, à l’hypnose, aux rêves, et à d’autres états de conscience modifiés, spontanés ou provoqués. Par exemple, l’idée que les phénomènes psiThouless et Wiesner ont introduit en 1942 lexpression "Phénomène psi" (et non "psy"), de la lettre grecque Psi, qui se voulait un terme neutre simplement destiné à désigner le "facteur inconnu" dans les expériences de parapsychologie, en opposition avec les communications sensori-motrices habituelles. On utilise ainsi le terme psi comme signifiant de façon générale une communication anormale avec lenvironnement (perceptions extra-sensorielles ou psychokinèse). On utilise fréquemment en parapsychologie les expressions de sujet psi, de perceptions psi et de phénomènes psi. puissent se produire durant la méditation est fréquente dans la plupart des textes classiques portant sur les techniques de méditation. La croyance en l’hypnose comme état pouvant induire des expériences psiThouless et Wiesner ont introduit en 1942 lexpression "Phénomène psi" (et non "psy"), de la lettre grecque Psi, qui se voulait un terme neutre simplement destiné à désigner le "facteur inconnu" dans les expériences de parapsychologie, en opposition avec les communications sensori-motrices habituelles. On utilise ainsi le terme psi comme signifiant de façon générale une communication anormale avec lenvironnement (perceptions extra-sensorielles ou psychokinèse). On utilise fréquemment en parapsychologie les expressions de sujet psi, de perceptions psi et de phénomènes psi. est également présente dès ses origines (Dingwall, 1968) ; et des études transculturelles indiquent que la plupart des expériences psiThouless et Wiesner ont introduit en 1942 lexpression "Phénomène psi" (et non "psy"), de la lettre grecque Psi, qui se voulait un terme neutre simplement destiné à désigner le "facteur inconnu" dans les expériences de parapsychologie, en opposition avec les communications sensori-motrices habituelles. On utilise ainsi le terme psi comme signifiant de façon générale une communication anormale avec lenvironnement (perceptions extra-sensorielles ou psychokinèse). On utilise fréquemment en parapsychologie les expressions de sujet psi, de perceptions psi et de phénomènes psi. spontanées sont rapportées comme s’étant produites lors de rêves (Green, 1960 ; Prasad et Stevenson, 1968 ; L.E. Rhine, 1962, Sannwald, 1959).

Il existe aujourd’hui des travaux expérimentaux qui corroborent ces observations. Par exemple, plusieurs chercheurs travaillant en laboratoire rapportent que la méditation facilite les phénomènes psiThouless et Wiesner ont introduit en 1942 lexpression "Phénomène psi" (et non "psy"), de la lettre grecque Psi, qui se voulait un terme neutre simplement destiné à désigner le "facteur inconnu" dans les expériences de parapsychologie, en opposition avec les communications sensori-motrices habituelles. On utilise ainsi le terme psi comme signifiant de façon générale une communication anormale avec lenvironnement (perceptions extra-sensorielles ou psychokinèse). On utilise fréquemment en parapsychologie les expressions de sujet psi, de perceptions psi et de phénomènes psi. (Honorton, 1977). Une méta-analyseAnalyse statistique prenant en compte de nombreuses expérimentations dun même type. de 25 expériences menées sur l’hypnose et le psiThouless et Wiesner ont introduit en 1942 lexpression "Phénomène psi" (et non "psy"), de la lettre grecque Psi, qui se voulait un terme neutre simplement destiné à désigner le "facteur inconnu" dans les expériences de parapsychologie, en opposition avec les communications sensori-motrices habituelles. On utilise ainsi le terme psi comme signifiant de façon générale une communication anormale avec lenvironnement (perceptions extra-sensorielles ou psychokinèse). On utilise fréquemment en parapsychologie les expressions de sujet psi, de perceptions psi et de phénomènes psi., entre 1945 et 1981, dans dix laboratoires différents, suggère que l’induction hypnotique peut aussi faciliter les perceptions psiThouless et Wiesner ont introduit en 1942 lexpression "Phénomène psi" (et non "psy"), de la lettre grecque Psi, qui se voulait un terme neutre simplement destiné à désigner le "facteur inconnu" dans les expériences de parapsychologie, en opposition avec les communications sensori-motrices habituelles. On utilise ainsi le terme psi comme signifiant de façon générale une communication anormale avec lenvironnement (perceptions extra-sensorielles ou psychokinèse). On utilise fréquemment en parapsychologie les expressions de sujet psi, de perceptions psi et de phénomènes psi. (Schechter, 1984). De plus, le psiThouless et Wiesner ont introduit en 1942 lexpression "Phénomène psi" (et non "psy"), de la lettre grecque Psi, qui se voulait un terme neutre simplement destiné à désigner le "facteur inconnu" dans les expériences de parapsychologie, en opposition avec les communications sensori-motrices habituelles. On utilise ainsi le terme psi comme signifiant de façon générale une communication anormale avec lenvironnement (perceptions extra-sensorielles ou psychokinèse). On utilise fréquemment en parapsychologie les expressions de sujet psi, de perceptions psi et de phénomènes psi. lors d’états oniriques a été étudié au cours d’une série d’expériences menées au Centre Médical Maimonides de New York et publiées entre 1966 et 1977 (Child, 1985 ; Ullman, Krippner et Vaughan, 1973).

Lors des recherches sur les rêves au Centre Médical Maimonides, deux sujets – un « percipient » (receiver) et un « agent »(sender) – passaient la nuit dans un laboratoire du sommeil. Les ondes cérébrales du percipientPersonne qui perçoit les pensées et les images transmises par télépathie. On utilise aussi parfois l'expression d'émetteur. et ses mouvements oculaires étaient enregistrés lors de son sommeil, alors qu’il se trouvait dans une pièce isolée. Quand le percipientPersonne qui perçoit les pensées et les images transmises par télépathie. On utilise aussi parfois l'expression d'émetteur. entrait en phase de sommeil paradoxal, l’expérimentateur pressait un bouton signalant à l’agentDans les cas spontanés, la personne vivant lévénement dont le récepteur va recevoir linformation ; dans les expérimentations de télépathie, lémetteur ; dans la psychokinèse :le sujet, considéré comme source du psi., situé dans une autre pièce, avec un autre expérimentateur, que la session commençait. L’agentDans les cas spontanés, la personne vivant lévénement dont le récepteur va recevoir linformation ; dans les expérimentations de télépathie, lémetteur ; dans la psychokinèse :le sujet, considéré comme source du psi. se concentrait alors sur une image choisie au hasard (la cibleDans lESP, lobjet ou lévénement que le récepteur cherche à deviner (cartes-cible, image-cible, sites-cible) ; dans la PK, lobjet, le processus ou le système que le sujet cherche à influencer (système-cible : souris, GNA, dés, etc.).) avec l’objectif d’influencer le contenu des rêves du percipientPersonne qui perçoit les pensées et les images transmises par télépathie. On utilise aussi parfois l'expression d'émetteur..

Vers la fin de la phase de sommeil paradoxal, le percipientPersonne qui perçoit les pensées et les images transmises par télépathie. On utilise aussi parfois l'expression d'émetteur. était réveillé. On lui demandait alors de décrire ses rêves. Cette procédure était répétée la nuit durant avec la même cibleDans lESP, lobjet ou lévénement que le récepteur cherche à deviner (cartes-cible, image-cible, sites-cible) ; dans la PK, lobjet, le processus ou le système que le sujet cherche à influencer (système-cible : souris, GNA, dés, etc.).. La transcription des rêves du percipientPersonne qui perçoit les pensées et les images transmises par télépathie. On utilise aussi parfois l'expression d'émetteur. était ensuite transmise à des juges extérieurs qui devaient noter à l’aveugle les similarités entre les rêves et les différentes images, l’une d’entre elle étant la « cible ».

Dans certaines recherches, c’étaient les percipients eux-mêmes qui faisaient office de juges. Lors des différentes reproductions de cette procédure, les transcriptions des rêves des percipients ont été jugés comme davantage similaires, et ce de façon significative, aux images « cibles » (que les agents devaient « transmettre » aux percipients) qu’aux autres images de l’ensemble (les leurres). (Les difficultés de reproduction de ces résultats ont également été analysées par Child, en 1985)

Ces différentes recherches ont inspiré un modèle opérationnel des processus psiThouless et Wiesner ont introduit en 1942 lexpression "Phénomène psi" (et non "psy"), de la lettre grecque Psi, qui se voulait un terme neutre simplement destiné à désigner le "facteur inconnu" dans les expériences de parapsychologie, en opposition avec les communications sensori-motrices habituelles. On utilise ainsi le terme psi comme signifiant de façon générale une communication anormale avec lenvironnement (perceptions extra-sensorielles ou psychokinèse). On utilise fréquemment en parapsychologie les expressions de sujet psi, de perceptions psi et de phénomènes psi. dans lequel des informations sont échangées sous forme d’un signal faible, habituellement masqué par un « bruit » provenant des perceptions sensorielles et somatiques.

On suppose que les divers états favorisant le psiThouless et Wiesner ont introduit en 1942 lexpression "Phénomène psi" (et non "psy"), de la lettre grecque Psi, qui se voulait un terme neutre simplement destiné à désigner le "facteur inconnu" dans les expériences de parapsychologie, en opposition avec les communications sensori-motrices habituelles. On utilise ainsi le terme psi comme signifiant de façon générale une communication anormale avec lenvironnement (perceptions extra-sensorielles ou psychokinèse). On utilise fréquemment en parapsychologie les expressions de sujet psi, de perceptions psi et de phénomènes psi., en réduisant les stimulations sensorielles externes, élèvent le ratio Signal/Bruit, augmentant ainsi la capacité d’une personne à détecter des informations induites par le psiThouless et Wiesner ont introduit en 1942 lexpression "Phénomène psi" (et non "psy"), de la lettre grecque Psi, qui se voulait un terme neutre simplement destiné à désigner le "facteur inconnu" dans les expériences de parapsychologie, en opposition avec les communications sensori-motrices habituelles. On utilise ainsi le terme psi comme signifiant de façon générale une communication anormale avec lenvironnement (perceptions extra-sensorielles ou psychokinèse). On utilise fréquemment en parapsychologie les expressions de sujet psi, de perceptions psi et de phénomènes psi. (Honorton, 1969, 1977). Pour tester l’hypothèse que la réduction des stimuli sensoriels facilite le psiThouless et Wiesner ont introduit en 1942 lexpression "Phénomène psi" (et non "psy"), de la lettre grecque Psi, qui se voulait un terme neutre simplement destiné à désigner le "facteur inconnu" dans les expériences de parapsychologie, en opposition avec les communications sensori-motrices habituelles. On utilise ainsi le terme psi comme signifiant de façon générale une communication anormale avec lenvironnement (perceptions extra-sensorielles ou psychokinèse). On utilise fréquemment en parapsychologie les expressions de sujet psi, de perceptions psi et de phénomènes psi., des chercheurs ont développé la procédure ganzfeldLe Ganzfeld (terme allemand qui signifie "champ sensoriel uniforme") est un protocole dinduction détat hypnagogique pour les expériences de télépathie. Le Ganzfeld est le protocole le plus utilisé actuellement en parapsychologie expérimentale. Il a été tout d'abord développé par Charles Honorton dans les années 1970. (Braud, Wood, Braud, 1975 ; Honorton et Harper, 1974, Parker, 1975) qui fut introduite à l’origine en psychologie expérimentale, durant les années 30, afin de tester des propositions issues de la Gestalt Théorie (Avant, 1965, Metzger, 1930)

Tout comme les recherches sur les rêves télépathiques, le protocole ganzfeldLe Ganzfeld (terme allemand qui signifie "champ sensoriel uniforme") est un protocole dinduction détat hypnagogique pour les expériences de télépathie. Le Ganzfeld est le protocole le plus utilisé actuellement en parapsychologie expérimentale. Il a été tout d'abord développé par Charles Honorton dans les années 1970. a le plus souvent été utilisé pour tester la communication télépathique entre un percipientPersonne qui perçoit les pensées et les images transmises par télépathie. On utilise aussi parfois l'expression d'émetteur. et un agentDans les cas spontanés, la personne vivant lévénement dont le récepteur va recevoir linformation ; dans les expérimentations de télépathie, lémetteur ; dans la psychokinèse :le sujet, considéré comme source du psi.. Le percipientPersonne qui perçoit les pensées et les images transmises par télépathie. On utilise aussi parfois l'expression d'émetteur. est installé dans un siège confortable situé dans une pièce isolée acoustiquement. Des moitiés de balles de ping-pong translucides sont placées sur ses yeux, tandis qu’il porte un casque sur ses oreilles. Une lampe émet un léger champ lumineux de couleur rouge dans la pièce, de façon à produire pour le percipientPersonne qui perçoit les pensées et les images transmises par télépathie. On utilise aussi parfois l'expression d'émetteur. un champ visuel indifférencié. Un bruit blanc est diffusé dans le casque audio pour obtenir un environnement auditif constant. C’est ce champ uniforme de perception, ainsi créé, qu’on appelle « ganzfeld ». Pour réduire le « bruit » interne du corps, le percipientPersonne qui perçoit les pensées et les images transmises par télépathie. On utilise aussi parfois l'expression d'émetteur. se soumet également à une série d’exercices de relaxation au début de la séance de ganzfeldLe Ganzfeld (terme allemand qui signifie "champ sensoriel uniforme") est un protocole dinduction détat hypnagogique pour les expériences de télépathie. Le Ganzfeld est le protocole le plus utilisé actuellement en parapsychologie expérimentale. Il a été tout d'abord développé par Charles Honorton dans les années 1970..

L’agentDans les cas spontanés, la personne vivant lévénement dont le récepteur va recevoir linformation ; dans les expérimentations de télépathie, lémetteur ; dans la psychokinèse :le sujet, considéré comme source du psi. est situé dans une autre pièce acoustiquement isolée, et un stimulus sensoriel (une image, une photo ou une brève séquence vidéo) est sélectionné au hasard, parmi un large éventail de choix, afin de servir de cibleDans lESP, lobjet ou lévénement que le récepteur cherche à deviner (cartes-cible, image-cible, sites-cible) ; dans la PK, lobjet, le processus ou le système que le sujet cherche à influencer (système-cible : souris, GNA, dés, etc.). pour l’expérience. Pendant que l’agentDans les cas spontanés, la personne vivant lévénement dont le récepteur va recevoir linformation ; dans les expérimentations de télépathie, lémetteur ; dans la psychokinèse :le sujet, considéré comme source du psi. se concentre sur la cibleDans lESP, lobjet ou lévénement que le récepteur cherche à deviner (cartes-cible, image-cible, sites-cible) ; dans la PK, lobjet, le processus ou le système que le sujet cherche à influencer (système-cible : souris, GNA, dés, etc.)., le percipientPersonne qui perçoit les pensées et les images transmises par télépathie. On utilise aussi parfois l'expression d'émetteur. rapporte verbalement ce qu’il perçoit mentalement tout le long de la session de ganzfeldLe Ganzfeld (terme allemand qui signifie "champ sensoriel uniforme") est un protocole dinduction détat hypnagogique pour les expériences de télépathie. Le Ganzfeld est le protocole le plus utilisé actuellement en parapsychologie expérimentale. Il a été tout d'abord développé par Charles Honorton dans les années 1970., pendant environ 30 minutes. Lorsque la session est terminée, on présente au percipientPersonne qui perçoit les pensées et les images transmises par télépathie. On utilise aussi parfois l'expression d'émetteur. plusieurs cibles (généralement quatre) et, sans savoir quelle est la bonne, il doit évaluer le degré de similarité de chaque cibleDans lESP, lobjet ou lévénement que le récepteur cherche à deviner (cartes-cible, image-cible, sites-cible) ; dans la PK, lobjet, le processus ou le système que le sujet cherche à influencer (système-cible : souris, GNA, dés, etc.). avec ce qu’il a perçu durant le ganzfeldLe Ganzfeld (terme allemand qui signifie "champ sensoriel uniforme") est un protocole dinduction détat hypnagogique pour les expériences de télépathie. Le Ganzfeld est le protocole le plus utilisé actuellement en parapsychologie expérimentale. Il a été tout d'abord développé par Charles Honorton dans les années 1970.. S’il retrouve la bonne cibleDans lESP, lobjet ou lévénement que le récepteur cherche à deviner (cartes-cible, image-cible, sites-cible) ; dans la PK, lobjet, le processus ou le système que le sujet cherche à influencer (système-cible : souris, GNA, dés, etc.)., celle sur laquelle l’agentDans les cas spontanés, la personne vivant lévénement dont le récepteur va recevoir linformation ; dans les expérimentations de télépathie, lémetteur ; dans la psychokinèse :le sujet, considéré comme source du psi. s’est concentré, la session est un succès. Si l’expérience utilise 4 cibles potentielles (la bonne cibleDans lESP, lobjet ou lévénement que le récepteur cherche à deviner (cartes-cible, image-cible, sites-cible) ; dans la PK, lobjet, le processus ou le système que le sujet cherche à influencer (système-cible : souris, GNA, dés, etc.). et 3 leurres), le taux de réussite dû au hasard est de 25%.

Les taux de succès peuvent également être analysées de manières différentes. Par exemple, ils peuvent être convertis en rangs de classement ou scores standardisés pour chaque essai et analysés paramétriquement pour l’ensemble des sessions. Et, de la même façon que pour les recherches sur les rêves télépathiques, le taux de similarité entre la description du percipientPersonne qui perçoit les pensées et les images transmises par télépathie. On utilise aussi parfois l'expression d'émetteur. et la cibleDans lESP, lobjet ou lévénement que le récepteur cherche à deviner (cartes-cible, image-cible, sites-cible) ; dans la PK, lobjet, le processus ou le système que le sujet cherche à influencer (système-cible : souris, GNA, dés, etc.). peut être évalué par des juges extérieurs qui utilisent des transcriptions écrites des verbalisations du percipientPersonne qui perçoit les pensées et les images transmises par télépathie. On utilise aussi parfois l'expression d'émetteur..

En 1985 et 1986, le Journal of Parapsychology a dédié deux numéros entiers à l’examen critique de la base de données provenant des expériences ganzfeldLe Ganzfeld (terme allemand qui signifie "champ sensoriel uniforme") est un protocole dinduction détat hypnagogique pour les expériences de télépathie. Le Ganzfeld est le protocole le plus utilisé actuellement en parapsychologie expérimentale. Il a été tout d'abord développé par Charles Honorton dans les années 1970.. Le numéro de 1985 comprenait deux contributions: (a) une méta-analyseAnalyse statistique prenant en compte de nombreuses expérimentations dun même type. et une critique de Ray Hyman, psychologue cognitiviste sceptique à propos de la recherche parapsychologique et (b) en réponse une méta-analyseAnalyse statistique prenant en compte de nombreuses expérimentations dun même type. effectuée par Charles HonortonCharles Honorton s'est intéressé très tôt à la parapsychologie. Adolescent, il échangea avec Joseph Rhine, et étudiant, il passa ses mois d'été au Laboratoire de Parapsychologie d’université de Duke en Caroline du Nord. Charles Honorton collabora avec Stanley Krippner et Montague Ullman au Maimonides Medical Center (Brooklyn, New York) lors des expériences de Rêve télépathique. Devenu directeur de la division de parapsychologie au Maimonides, il fonda en 1979 le Psychophysical Research Laboratories (PRL) à Princeton dans le New Jersey. Il est décédé en 1992 laissant derrière lui un nombre important de publications de parapsychologie, sa principale contribution en parapsychologie étant le développement du protocole Ganzfeld. More (1985), parapsychologueCe terme revêt de nos jours un double sens. Utilisé pour désigner les chercheurs de formation scientifique et universitaire qui étudient les phénomènes paranormaux dans le cadre de la parapsychologie scientifique, il renvoie aussi aux praticiens de l'occulte et du paranormal (voyants, médiums, magnétiseurs, etc.). On pourrait souhaiter que la première acception évoquée l'emporte dans le vocabulaire courant pour ainsi éviter toute confusion. L'ambiguïté du terme est volontiers entretenue par les critiques et détracteurs de la parapsychologie scientifique. Ceux-ci tentent ainsi, par un pernicieux effet d'amalgame maintenant une certaine confusion sémantique, de reléguer des recherches se voulant rationnelles sur ces questions en dehors du champ de la science. Des praticiens du paranormal peuvent avoir tendance, eux aussi, à entretenir cette ambiguïté. En se prétendant parapsychologues, ils espèrent sans doute, par la référence scientifique qu'ils s'attribuent, renforcer auprès de leurs clients l'image de professions en manque de reconnaissance sociale. De plus, le peu d'approfondissement que des enquêtes médiatiques trop souvent en mal de sensationnel consacrent à ce type de questions contribue à laisser perdurer la confusion, là où il faudrait au contraire faire preuve de discernement et de prudence. Que pouvons-nous dire des parapsychologues relevant du premier sens envisagé et que nous voudrions privilégier ici? D'origines universitaires variées, les chercheurs amenés à réfléchir aux questions parapsychologiques se recrutent aussi bien parmi des spécialistes des sciences dites humaines (psychologues, ethnologues, sociologues, etc.) que parmi des spécialistes des sciences dites exactes (mathématiciens, physiciens, biologistes, etc.). Des philosophes, des médecins et des ingénieurs se retrouvent également impliqués dans ce domaine de recherche. Seuls quelques laboratoires dans le monde emploient des chercheurs en parapsychologie à temps plein. Compte tenu du peu de place que l'institution scientifique accorde encore à la parapsychologie, la plupart des chercheurs n'y consacrent qu'une partie de leur temps, exerçant par ailleurs des fonctions en lien avec leur formation d'origine. Les premiers grands noms de la parapsychologie furent les pionniers de recherches qualifiées alors de psychiques , ou bien encore de métapsychiques. Parmi les plus connus, on pourrait citer le philosophe américain William James (1842-1910), tenant du pragmatisme, le physicien anglais William Crookes (1829-1919), rendu par ailleurs célèbre par la découverte du thallium, et le Français Charles Richet (1850-1935), prix Nobel de médecine en 1913. Deux psychologues américains ont ensuite particulièrement marqué l'histoire de la parapsychologie durant la seconde moitié du XXème siècle. Joseph Banks Rhine (1925-1980) est considéré comme le père de la parapsychologie quantitative car il a systématisé le traitement statistique des phénomènes paranormaux observés en laboratoire. Plus près de nous, Charles Honorton, en introduisant la technique du ganzfeld et en appliquant les techniques de méta-analyses aux données parapsychologiques, a permis de faire avancer le débat entre partisans et opposants de la parapsychologie. En France, c'est essentiellement autour de l'Institut métapsychique international, fondé en 1919, que se sont regroupés les principaux intellectuels interessés par ces questions. On citera, pour mémoire, les docteurs Gustave Geley (1865-1924) et Eugène Osty (1874-1938) ou bien encore les ingénieurs René Warcollier (1881-1962) et Henri Marcotte (1920-1987). Le spécialiste d'éthologie animale Rémy Chauvin, membre de l'Académie des sciences, est certainement, à l'heure actuelle, le scientifique le plus connu du grand public qui ait ouvertement déclaré son intérêt pour la parapsychologie, par le biais notamment d'expériences réalisées avec des animaux. Ce sont en fait de très nombreux chercheurs (qu'il faudrait certainement compter en milliers), issus de mondes scientifiques et intellectuels très divers, qui se sont passionnés pour la parapsychologie depuis plus d'un siècle, aussi bien en Europe qu'aux États-Unis, comme dans l'ex-URSS ou d'autres pays du monde. Dans son ouvrage "Somnambulisme et médiumnité" et plus particulièrement dans le tome II intitulé "Le Choc des sciences psychiques", le philosophe et sociologue Bertrand Meheust, reprenant l'histoire des débuts de la métapsychique, tente de comprendre les origines de l'incroyable entreprise d'occultation qui a pesé et qui pèse encore sur les travaux de plusieurs générations de parapsychologues. {Par Paul-Louis Rabeyron (extrait du dictionnaire des miracles et de l'extraordinaire chrétien, rédigé sous la direction de Patrick Sbalchiero, Fayard, 2000)} qui fut l’un des principaux chercheurs à avoir mis en place le ganzfeldLe Ganzfeld (terme allemand qui signifie "champ sensoriel uniforme") est un protocole dinduction détat hypnagogique pour les expériences de télépathie. Le Ganzfeld est le protocole le plus utilisé actuellement en parapsychologie expérimentale. Il a été tout d'abord développé par Charles Honorton dans les années 1970.. L’article de 1986 contenait quatre commentaires portant sur l’échange Hyman-Honorton, un communiqué co-signé d’Hyman et Honorton et six commentaires additionnels sur ce communiqué en question. Nous résumons ici les points majeurs et les conclusions tirés de ces échanges.

Taux de reproduction

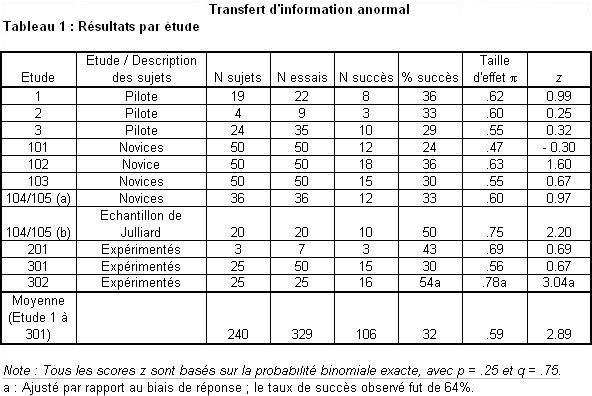

Taux par études.

La méta-analyseAnalyse statistique prenant en compte de nombreuses expérimentations dun même type. d’Hyman portait sur 42 études ganzfeldLe Ganzfeld (terme allemand qui signifie "champ sensoriel uniforme") est un protocole dinduction détat hypnagogique pour les expériences de télépathie. Le Ganzfeld est le protocole le plus utilisé actuellement en parapsychologie expérimentale. Il a été tout d'abord développé par Charles Honorton dans les années 1970., provenant de 34 publications allant de 1974 jusqu’à 1981 inclus. L’un des premiers problèmes qu’il rencontra lors de l’étude de la base de données des expériences ganzfeldLe Ganzfeld (terme allemand qui signifie "champ sensoriel uniforme") est un protocole dinduction détat hypnagogique pour les expériences de télépathie. Le Ganzfeld est le protocole le plus utilisé actuellement en parapsychologie expérimentale. Il a été tout d'abord développé par Charles Honorton dans les années 1970. fut la multiplicité des analyses. Comme nous l’avons indiqué précédemment, il est possible de calculer de façons différentes les performances psiThouless et Wiesner ont introduit en 1942 lexpression "Phénomène psi" (et non "psy"), de la lettre grecque Psi, qui se voulait un terme neutre simplement destiné à désigner le "facteur inconnu" dans les expériences de parapsychologie, en opposition avec les communications sensori-motrices habituelles. On utilise ainsi le terme psi comme signifiant de façon générale une communication anormale avec lenvironnement (perceptions extra-sensorielles ou psychokinèse). On utilise fréquemment en parapsychologie les expressions de sujet psi, de perceptions psi et de phénomènes psi. lors d’une expérience de type ganzfeldLe Ganzfeld (terme allemand qui signifie "champ sensoriel uniforme") est un protocole dinduction détat hypnagogique pour les expériences de télépathie. Le Ganzfeld est le protocole le plus utilisé actuellement en parapsychologie expérimentale. Il a été tout d'abord développé par Charles Honorton dans les années 1970. et, de plus, il est possible d’étudier ces résultats selon de multiples traitements statistiques. De nombreux chercheurs ont utilisé plusieurs grilles d’évaluations ou ont appliqué des tests statistiques différents sans ajuster les critères de significativité au nombre d’analyses effectuées. Pire, certains chercheurs ont même recherché parmi les différentes possibilités d’analyses jusqu’à en trouver une qui mène à un résultat significatif. Honorton était d’accord pour dire qu’il s’agissait là d’un réel problème.

En conséquence, Honorton appliqua un test homogène à partir d’une grille d’analyse identique sur toutes les études, afin d’en extraire des données pertinentes, et sans se soucier de la façon dont les chercheurs avaient analysé les données dans leurs rapports d’origine. Il sélectionna la proportion de succès en tant qu’index commun car elle pouvait être calculée sur le plus grand nombre d’études (28 études sur 42). Ce taux de réussite est également un indice minimal car il met de côté la plupart des autres informations évaluées ; la bonne cibleDans lESP, lobjet ou lévénement que le récepteur cherche à deviner (cartes-cible, image-cible, sites-cible) ; dans la PK, lobjet, le processus ou le système que le sujet cherche à influencer (système-cible : souris, GNA, dés, etc.). classée en deuxième position, un essai « presque réussi », n’est ainsi pas mieux noté qu’un essai manqué. Honorton calcula ensuite la probabilité binomiale exacte et l’associa au score z pour chacune des études.

Sur les 28 études, 23 (soit 82%) ont obtenu des score z positifs (p=4.6 x 10E-4, test de loi binomiale avec p=q=.5). Douze des études (soit 43%) eurent des scores significatifs de façon indépendante, avec un seuil de significativité à 5% (p=3.5 x 10E-9, test binomial avec 28 études, p=.05 et q=.95) et 7 des études menées (soit 25%) eurent des scores significatifs de façon indépendante avec un seuil à 1% (p=9,8 x E-9). Le Stouffer-z fut de 6.60 sur les 28 études (p=2.1 x 10E-11)[[Le Stouffer-z est calculé en divisant la somme des scores z pour les études individuelles par la racine carrée du nombre d’études (Rosenthal, 1978).]]

(note: Le Stouffer-z est obtenu en divisant la somme des scores z pour les études individuelles par la racine carrée du nombre d’études (Rosenthal, 1978))

Une estimation plus prudente de la significativité peut être obtenue en incluant 10 études supplémentaires qui ont aussi utilisé la procédure adéquate de jugement mais qui n’indiquent pas le taux de succès. Si on assigne à ces études un score z moyen nul, le Stouffer-z est de 5.67 (p=7.3 x E-9) sur les 38 études.

Ainsi, que l’on considère uniquement les études pour lesquelles les informations nécessaires à l’évaluation sont disponibles, ou que l’on estime comme conformes au hasard les résultats des études additionnelles pour lesquelles ces informations ne sont pas disponibles, les résultats rassemblés ne peuvent pas raisonnablement être attribués au hasard. Et, par conception, le résultat cumulatif rapporté ne peut pas être attribué au gonflement des niveaux de signification par des analyses multiples.

Les taux par laboratoires :

L’une des objections quant aux estimations telles que celles que nous venons de décrire est que les études en provenance d’un même laboratoire ne sont pas indépendantes les unes des autres.

Ainsi, il est possible pour un ou deux chercheurs d’être disproportionnellement responsables d’un fort taux de reproduction des résultats alors que d’autres chercheurs, indépendants de ceux-là, sont incapables d’obtenir le même effet. Effectivement, la base de données ganzfeldLe Ganzfeld (terme allemand qui signifie "champ sensoriel uniforme") est un protocole dinduction détat hypnagogique pour les expériences de télépathie. Le Ganzfeld est le protocole le plus utilisé actuellement en parapsychologie expérimentale. Il a été tout d'abord développé par Charles Honorton dans les années 1970. pourrait être soumise à cette critique. Les 28 études indiquant le taux de succès ont été conduites par des chercheurs provenant de dix laboratoires différents. Un laboratoire a contribué 9 de ces études, le laboratoire de Honorton en a fourni 5, 2 autres laboratoires en ont fourni 3 chacun, 2 ont contribué à 2 chacun, et les 4 labos restants ont chacun fourni 1 étude. Ainsi, la moitié des études ont été conduites par seulement deux laboratoires, dont l’un était celui de Honorton.

En fonction de tout cela, Honorton a calculé pour chaque laboratoire un score Stouffer-z. Des résultats significatifs et positifs ont été signalés par 6 des 10 labos, et les score z combinés sur l’ensemble des labos a été de 6.16 (p= 3.6 x E-10). Même si toutes les études conduites par deux des laboratoires les plus prolifiques sont écartées de l’analyse, le Stouffer-z de l’ensemble des 8 labos reste significatif (z=3.67, p)1.2 x E-4). Quatre de ces études sont significatives à 1% (p=9.2 x E-6, test binaire avec 14 études, p=0.01 et q=0.99) et chacune a été fournie par un laboratoire différent. Ainsi, même si le nombre total de laboratoires dans cette base de données est petit, la plupart de ces laboratoires ont publié des études significatives, et la pertinence de l’ensemble de l’effet obtenu ne dépend pas d’un ou deux laboratoires seulement.

La sélection des publications

Ces dernières années, les chercheurs en sciences du comportement sont devenus davantage conscients du problème dit de « l’effet tiroir » : c’est à dire le fait que les études menées avec succès et ayant des résultats significatifs ont de fortes chances d’être publiées, alors que les recherches ne donnant pas lieu à des résultats probants sont plus aptes à être laissées dans les tiroirs de quelques chercheurs déçus (Bozart & Roberts, 1972 ; Sterling, 1959).

Les parapsychologues ont été parmi les premiers à être sensibilisés à ce problème et, en 1975, le Conseil de la Parapsychological AssociationLa Parapsychological Association (PA) est une organisation internationale constituée de scientifiques et d'universitaires qui étudient les phénomènes psi, comme la télépathie, la clairvoyance, la psychokinèse, la guérison psychique ou la précognition. La Parapsychological Association est reconnue comme une association scientifique à part entière, étant membre de l'AAAS depuis 1969. C'est le plus important organisme de recherche en parapsychologie. La plupart des parapsychologues sont membre de PA. elle permet de féderer l'ensemble des chercheurs travaillant dans le domaine de la parapsychologie et organise chaque année un congrès où sont publiées les recherches scientifiques des parapsychologues. Elle a pour objectif de promouvoir l'approche scientifique et objective des phénomènes psi et ses membres obeissent à une charte de déontologie. (PAC) a adopté une politique s’opposant à la sélection des publications de recherches en fonction de leurs résultats. En conséquence, les résultats négatifs ont systématiquement été rapportés lors des congrès de la PA et dans les publications associées à celle-ci, et cela depuis environ deux décennies.

Comme nous l’avons montré précédemment, plus de la moitié des études ganzfeldLe Ganzfeld (terme allemand qui signifie "champ sensoriel uniforme") est un protocole dinduction détat hypnagogique pour les expériences de télépathie. Le Ganzfeld est le protocole le plus utilisé actuellement en parapsychologie expérimentale. Il a été tout d'abord développé par Charles Honorton dans les années 1970. comprises dans les méta-analyses ont fourni des résultats dont l’indice p de signification tombe bien au-dessous du niveau conventionnel de 0.05.

Une variante du problème de sélection des rapports ressort de ce que Hyman appelle « l’étude rétrospective » (1985). Un chercheur conduit un petit nombre d’essais exploratoires. S’ils fournissent des résultats nuls, ils restent vus comme des essais d’exploration et ne font jamais partie de la version officielle de l’étude. En revanche, s’ils fournissent des résultats positifs, ils sont définis a posteriori en tant qu’étude réelle et sont soumis à publication. Pour corroborer cette hypothèse, Hyman a remarqué qu’il y avait plus d’études significatives de moins de 20 essais dans la base de données que l’on aurait pu s’y attendre, selon l’assertion que, toutes choses étant égales par ailleurs, la signification statistiqueUn résultat est dit généralement significatif lorsquil ny a pas plus de 5 chances sur 100 que ce même résultat ait été produit par les fluctuations du hasard ; ce qui correspond à une probabilité p de 5 % soit p = 0,05 (on utilise aussi parfois un seuil de significativité à 1 % soit p = 0,01). augmente avec la taille de l’échantillon. Bien que Honorton ait remis en question cette affirmation que « toutes choses étaient égales par ailleurs » et était en désaccord avec l’analyse statistique d’Hyman, il a admis le fait qu’il y avait une apparente sur-représentation des études significatives de moins de 20 essais. (Sur la totalité de la base de données ganzfeldLe Ganzfeld (terme allemand qui signifie "champ sensoriel uniforme") est un protocole dinduction détat hypnagogique pour les expériences de télépathie. Le Ganzfeld est le protocole le plus utilisé actuellement en parapsychologie expérimentale. Il a été tout d'abord développé par Charles Honorton dans les années 1970., soit 42 études, 8 comportaient moins de 20 essais, et 6 d’entre elles ont donné des résultats statistiques significatifs).

Parce qu’il est impossible, par définition, de savoir combien d’études inconnues (exploratoires ou autres) restent au fond des tiroirs, l’outil principal d’estimation de la gravité des problèmes de sélection de rapports est maintenant constitué d’une variante des statistiques de Rosenthal : il s’agit d’estimer combien d’études non-rapportées, avec un score-Z de 0, seraient nécessaires pour annuler le score-Z cumulatif d’études publiées (Rosenthal, 1979). Pour annuler le resultat cumulatif des 28 études ganzfeldLe Ganzfeld (terme allemand qui signifie "champ sensoriel uniforme") est un protocole dinduction détat hypnagogique pour les expériences de télépathie. Le Ganzfeld est le protocole le plus utilisé actuellement en parapsychologie expérimentale. Il a été tout d'abord développé par Charles Honorton dans les années 1970., utilisant la mesure de réussite-directe, on estime que le nombre d’études non rapportées serait de 423, une proportion énorme de 15 contre 1. Quand on sait que conduire une seule session ganzfeldLe Ganzfeld (terme allemand qui signifie "champ sensoriel uniforme") est un protocole dinduction détat hypnagogique pour les expériences de télépathie. Le Ganzfeld est le protocole le plus utilisé actuellement en parapsychologie expérimentale. Il a été tout d'abord développé par Charles Honorton dans les années 1970. prend plus d’une heure, il n’est pas surprenant qu’en dépit de son souci concernant l’étude rétrospective, Hyman s’accorda avec Honorton – et avec d’autres collaborateurs du débat publié – à conclure que le biaisPrésence de patterns ou de défauts particuliers pouvant introduire une modification arbitraire des résultats et faussant ainsi leur validité (ex : un dé non équilibré ayant tendance à faire sortir souvent le même chiffre). des rapports sélectifs ne pouvait rendre compte de façon plausible de la significativité globale de l’ensemble des études ganzfeldLe Ganzfeld (terme allemand qui signifie "champ sensoriel uniforme") est un protocole dinduction détat hypnagogique pour les expériences de télépathie. Le Ganzfeld est le protocole le plus utilisé actuellement en parapsychologie expérimentale. Il a été tout d'abord développé par Charles Honorton dans les années 1970. (Hyman & Honorton, 1986). [[Un sondage auprès des parapsychologues_en 1980 a révélé seulement 19 études ganzfeldLe Ganzfeld (terme allemand qui signifie "champ sensoriel uniforme") est un protocole dinduction détat hypnagogique pour les expériences de télépathie. Le Ganzfeld est le protocole le plus utilisé actuellement en parapsychologie expérimentale. Il a été tout d'abord développé par Charles Honorton dans les années 1970. terminées mais non publiées. Sept d’entre elles avaient des résultats positifs significatifs, une proportion (37%) très similaire à la proportion des autres études significatives de la méta-analyseAnalyse statistique prenant en compte de nombreuses expérimentations dun même type. (43%) (Blackmore, 1980).]]

Défauts méthodologiques

Si la critique la plus fréquente concernant la parapsychologieEtude rationnelle et pluridisciplinaire des faits semblant inexplicables dans l'état actuel de nos connaissances, et mettant en jeu directement le psychisme et son interaction avec l'environnement. C'est en 1889 que l'Allemand Max DESSOIR proposa les termes de parapsychologie pour "caractériser toute une région frontière encore inconnue qui sépare les états psychologiques habituels des états pathologiques", et de paraphysique pour désigner des phénomènes objectifs qui paraissent échapper aux lois de la physique classique. On parle plus spécifiquement de parapsychologie expérimentale pour désigner la parapsychologie dans le cadre du laboratoire. More est le fait qu’il n’existe pas d’effet psiThouless et Wiesner ont introduit en 1942 lexpression "Phénomène psi" (et non "psy"), de la lettre grecque Psi, qui se voulait un terme neutre simplement destiné à désigner le "facteur inconnu" dans les expériences de parapsychologie, en opposition avec les communications sensori-motrices habituelles. On utilise ainsi le terme psi comme signifiant de façon générale une communication anormale avec lenvironnement (perceptions extra-sensorielles ou psychokinèse). On utilise fréquemment en parapsychologie les expressions de sujet psi, de perceptions psi et de phénomènes psi. reproductible, la seconde critique la plus habituelle est que de nombreuses expériences parapsychologiques, sinon la plupart, ont des contrôles et des garanties de protocole insuffisantes.

Une accusation fréquente est que les résultats positifs sont issus principalement des premières études faiblement contrôlées et qu’ils disparaissent dès que de meilleurs contrôles et des garanties suffisantes sont introduits. Heureusement, la méta-analyseAnalyse statistique prenant en compte de nombreuses expérimentations dun même type. permet d’évaluer concrètement dans quelle mesure les défauts méthodologiques peuvent avoir contribué artificiellement à des résultats positifs dans une série d’études. Tout d’abord, des cotes sont attribuées à chaque étude qui indiquent à quel degré chaque défaut méthodologique particulier est présent ou non ; ces cotations sont ensuite corrélées avec les résultats des études. Des corrélations grandement positives constituent la preuve que l’effet observé puisse être artefactuel. En recherche psiThouless et Wiesner ont introduit en 1942 lexpression "Phénomène psi" (et non "psy"), de la lettre grecque Psi, qui se voulait un terme neutre simplement destiné à désigner le "facteur inconnu" dans les expériences de parapsychologie, en opposition avec les communications sensori-motrices habituelles. On utilise ainsi le terme psi comme signifiant de façon générale une communication anormale avec lenvironnement (perceptions extra-sensorielles ou psychokinèse). On utilise fréquemment en parapsychologie les expressions de sujet psi, de perceptions psi et de phénomènes psi., les défauts les plus cruciaux sont ceux qui pourraient permettre au sujet d’obtenir l’information cibleDans lESP, lobjet ou lévénement que le récepteur cherche à deviner (cartes-cible, image-cible, sites-cible) ; dans la PK, lobjet, le processus ou le système que le sujet cherche à influencer (système-cible : souris, GNA, dés, etc.). d’une manière sensorielle normale, que ce soit par inadvertance ou en trichant délibérément. C’est ce que l’on appelle le problème de fuite sensorielle. Un autre défaut potentiellement grave est celui de « randomisation » : que la sélection de la cibleDans lESP, lobjet ou lévénement que le récepteur cherche à deviner (cartes-cible, image-cible, sites-cible) ; dans la PK, lobjet, le processus ou le système que le sujet cherche à influencer (système-cible : souris, GNA, dés, etc.). n’a pas été basée sur un processus suffisamment aléatoire.

Fuite sensorielle

Comme le ganzfeldLe Ganzfeld (terme allemand qui signifie "champ sensoriel uniforme") est un protocole dinduction détat hypnagogique pour les expériences de télépathie. Le Ganzfeld est le protocole le plus utilisé actuellement en parapsychologie expérimentale. Il a été tout d'abord développé par Charles Honorton dans les années 1970. est en lui-même une procédure d’isolation perceptive, on va très loin pour éliminer toutes fuites sensorielles potentielles durant la partie ganzfeldLe Ganzfeld (terme allemand qui signifie "champ sensoriel uniforme") est un protocole dinduction détat hypnagogique pour les expériences de télépathie. Le Ganzfeld est le protocole le plus utilisé actuellement en parapsychologie expérimentale. Il a été tout d'abord développé par Charles Honorton dans les années 1970. de la séance. Il y a, cependant, des canaux potentiels de fuite sensorielle après la période de ganzfeldLe Ganzfeld (terme allemand qui signifie "champ sensoriel uniforme") est un protocole dinduction détat hypnagogique pour les expériences de télépathie. Le Ganzfeld est le protocole le plus utilisé actuellement en parapsychologie expérimentale. Il a été tout d'abord développé par Charles Honorton dans les années 1970.. Par exemple, si l’expérimentateur qui interagit avec le receveur connaît l’identité de la cibleDans lESP, lobjet ou lévénement que le récepteur cherche à deviner (cartes-cible, image-cible, sites-cible) ; dans la PK, lobjet, le processus ou le système que le sujet cherche à influencer (système-cible : souris, GNA, dés, etc.)., il ou elle pourrait biaiser les appréciations de similarité du percipientPersonne qui perçoit les pensées et les images transmises par télépathie. On utilise aussi parfois l'expression d'émetteur. dans le sens d’une identification correcte de la cibleDans lESP, lobjet ou lévénement que le récepteur cherche à deviner (cartes-cible, image-cible, sites-cible) ; dans la PK, lobjet, le processus ou le système que le sujet cherche à influencer (système-cible : souris, GNA, dés, etc.).. Une seule étude de la base de données présente ce défaut, une étude dans laquelle les sujets ont en fait obtenu une performance légèrement inférieure à celle due au hasard. Deuxièmement, si le stimulus que le receveur doit juger est la cibleDans lESP, lobjet ou lévénement que le récepteur cherche à deviner (cartes-cible, image-cible, sites-cible) ; dans la PK, lobjet, le processus ou le système que le sujet cherche à influencer (système-cible : souris, GNA, dés, etc.). physique que l’émetteur avait dans les mains durant la période de transmission, il pourrait y avoir des signaux (par exemple, des traces de doigt, des tâches ou des différences de température) qui pourraient distinguer la cibleDans lESP, lobjet ou lévénement que le récepteur cherche à deviner (cartes-cible, image-cible, sites-cible) ; dans la PK, lobjet, le processus ou le système que le sujet cherche à influencer (système-cible : souris, GNA, dés, etc.). des leurres. De plus, le procédé de transfert du matériel – stimulus dans la pièce du receveur ouvre en lui-même d’autres canaux potentiels de fuite sensorielle. Bien que les études de ganzfeldLe Ganzfeld (terme allemand qui signifie "champ sensoriel uniforme") est un protocole dinduction détat hypnagogique pour les expériences de télépathie. Le Ganzfeld est le protocole le plus utilisé actuellement en parapsychologie expérimentale. Il a été tout d'abord développé par Charles Honorton dans les années 1970. contemporaines aient éliminé ces deux possibilités en utilisant des séries de stimulus dupliquées, ce n’est pas le cas de certaines études antérieures.

Des analyses indépendantes menées par Hyman et Honorton ont convenu qu’il n’y a pas de corrélation entre l’insuffisance de sécurité par rapport à la fuite sensorielle et le résultat de l’étude. Honorton a d’ailleurs rapporté que même si les études qui n’utilisaient pas de séries de stimulus dupliquées étaient écartées de l’analyse, les études restantes sont encore hautement significatives (Stouffer-z = 4.35, p = 6.8xE-6)

Randomisation

Dans beaucoup d’expériences psiThouless et Wiesner ont introduit en 1942 lexpression "Phénomène psi" (et non "psy"), de la lettre grecque Psi, qui se voulait un terme neutre simplement destiné à désigner le "facteur inconnu" dans les expériences de parapsychologie, en opposition avec les communications sensori-motrices habituelles. On utilise ainsi le terme psi comme signifiant de façon générale une communication anormale avec lenvironnement (perceptions extra-sensorielles ou psychokinèse). On utilise fréquemment en parapsychologie les expressions de sujet psi, de perceptions psi et de phénomènes psi., le problème de randomisation de la cibleDans lESP, lobjet ou lévénement que le récepteur cherche à deviner (cartes-cible, image-cible, sites-cible) ; dans la PK, lobjet, le processus ou le système que le sujet cherche à influencer (système-cible : souris, GNA, dés, etc.). est des plus importants, car si les séquences de cibles ne sont pas réellement aléatoires, alors des patterns systématiques pourraient être détectées par les sujets durant la session ou pourraient concorder avec les biaisPrésence de patterns ou de défauts particuliers pouvant introduire une modification arbitraire des résultats et faussant ainsi leur validité (ex : un dé non équilibré ayant tendance à faire sortir souvent le même chiffre). de réponse préexistants des sujets. Dans une étude ganzfeldLe Ganzfeld (terme allemand qui signifie "champ sensoriel uniforme") est un protocole dinduction détat hypnagogique pour les expériences de télépathie. Le Ganzfeld est le protocole le plus utilisé actuellement en parapsychologie expérimentale. Il a été tout d'abord développé par Charles Honorton dans les années 1970., toutefois, la randomisation est un problème beaucoup moins critique car une seule cibleDans lESP, lobjet ou lévénement que le récepteur cherche à deviner (cartes-cible, image-cible, sites-cible) ; dans la PK, lobjet, le processus ou le système que le sujet cherche à influencer (système-cible : souris, GNA, dés, etc.). est choisie pendant la session et la plupart des sujets ne participent qu’à une seule session. Mais l’essentiel est que tous les stimuli dans chaque groupe de jugement soient répartis aléatoirement sur l’ensemble du déroulement de l’étude. Des considérations semblables affectent la seconde randomisation qui a lieu après la séance ganzfeldLe Ganzfeld (terme allemand qui signifie "champ sensoriel uniforme") est un protocole dinduction détat hypnagogique pour les expériences de télépathie. Le Ganzfeld est le protocole le plus utilisé actuellement en parapsychologie expérimentale. Il a été tout d'abord développé par Charles Honorton dans les années 1970. et détermine l’ordre dans lequel la cibleDans lESP, lobjet ou lévénement que le récepteur cherche à deviner (cartes-cible, image-cible, sites-cible) ; dans la PK, lobjet, le processus ou le système que le sujet cherche à influencer (système-cible : souris, GNA, dés, etc.). et les leurres sont présentés au percipientPersonne qui perçoit les pensées et les images transmises par télépathie. On utilise aussi parfois l'expression d'émetteur. (ou au juge externe) pour évaluation.

Néanmoins, Hyman et Honorton ne sont pas d’accord sur ces résultats. Hyman a affirmé qu’il y a corrélation entre les défauts de randomisation et les résultats de l’étude ; Honorton a affirmé qu’il n’y en a pas. La source de ce désaccord provient :

des définitions contradictoires des catégories de défauts méthodologiques,

du codage et de l’attribution des cotations des défauts pour les études individuelles,

et du traitement statistique à partir de ces cotations.

Malheureusement, il n’y a pas eu de cotations des défauts par des évaluateurs indépendants qui n’étaient pas au courant des résultats des études (Morris, 1991). Néanmoins, aucun de ceux qui ont contribué au débat qui s’en est suivi n’ont partagé la conclusion d’Hyman alors que quatre non parapsychologues – deux statisticiens et deux psychologues – ont explicitement partagé la conclusion d’Honorton (Harris & Rosenthal, 1988b ; Saunders, 1985 ; Utts, 1991a). Par exemple, Harris et Rosenthal (un des pionniers de l’utilisation de la méta-analyseAnalyse statistique prenant en compte de nombreuses expérimentations dun même type. en psychologie) ont utilisé les propres cotations de défauts d’Hyman et n’ont pas trouvé de relation significative entre les défauts de randomisation et les résultats de l’étude dans chacune des deux analyses distinctes : « Notre analyse des effets des défauts de randomisation sur les résultats des études ne corrobore pas l’hypothèse que les résultats de la recherche ganzfeldLe Ganzfeld (terme allemand qui signifie "champ sensoriel uniforme") est un protocole dinduction détat hypnagogique pour les expériences de télépathie. Le Ganzfeld est le protocole le plus utilisé actuellement en parapsychologie expérimentale. Il a été tout d'abord développé par Charles Honorton dans les années 1970. seraient liés significativement á une série de défauts. » (1988b, p 3 ; pour un échange plus récent concernant l’analyse d’Hyman, voir Hyman, 1991 ; Utts, 1991a, 1991b)

Taille d’effet